ウェブサイトをリニューアルしたのち、Search ConsoleのURL検査でインデックスの登録をリクエストした際に、robots.txtにブロックされることがあります。

リニューアル後のウェブサイトはWordPressで作成しており、WordPressから出力されるrobots.txtの中身をチェックしましたが、ブロックしている記述もなく正常に出力されていました。

目次

原因は新しいウェブサイトをアップした中途半端なタイミングでrobots.txtがクロールされていた

ウェブサイトをリニューアルしたため、新しいデータをサーバーにアップをしました。

たまたま新しいデータをサーバーにアップしている途中の時間帯にrobots.txtがクロールされてしまい、中身がおかしな状態のrobots.txtがクロールされてしまったことが原因でした。

同様の問題でsitemap.xmlもSearch Consoleで登録できなくなっていました。

robots.txtがブロックされることはまれにあるようですが、時間経過で解決することもあったりrobots.txtそもそもの記述自体がクローラーをブロックする記述がされているケースもあるようです。

robots.txtの再クロールで解決

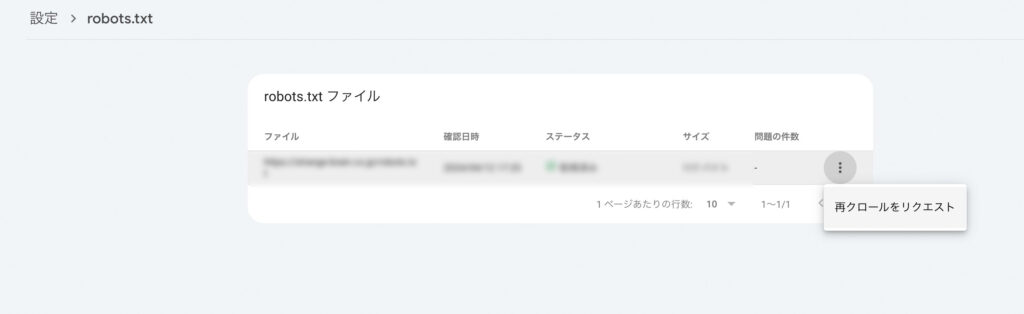

Search Consoleから最新のrobots.txtを再クロールさせることで解決しました。

- 設定→

- robots.txt→レポートを開く→

- 再クロールをリクエスト

robots.txtの確認日時が、データをアップしている最中の時間帯になっていたため、中途半端な状態のrobots.txtがクロールされたことで原因は間違いなさそうでした。

上記の手順で再クロールをリクエストすることで最新のrobots.txtがクロールされて無事に解決しました。